El archivo robots.txt es un archivo que nos ayuda a gestionar las páginas a las que pueden acceder los rastreadores de los diferentes buscadores.

Robots txt: Qué es y cómo crear el archivo robots. Mejora el rastreo de tu web optimizando tu archivo robots.txt BIEN Compartir en XEn este post vamos a hablar de:

¿Qué es el Robots.txt?

El robots.txt es un archivo de texto plano, sin formato, que recoge una serie de directivas orientadas a los diferentes rastreadores web.

Lo primero que hacen los bots de los diferentes buscadores cuando llegan a una página web es fijarse en la raíz del dominio, que es dónde está ubicado el archivo robots txt, lo leen y comienzan a rastrear el sitio.

El robots.txt no es una manera de evitar que una página aparezca en Google. Si queremos controlar lo que aparece en las SERPs debemos usar la etiqueta «no index«, no incluir la página en el sitemap o proteger la página con una contraseña, registro o un cinturón de castidad no apto para bots.

Antes de continuar te voy a dejar este vídeo para que veas la diferencia entre rastreo e indexación:

Podemos resumir que el rastreo consiste en economizar el tiempo que Google pasa en nuestro sitio web.

Qué utilidad tiene el archivo robots txt en el SEO

Muchas veces sabemos que tenemos que hacer cosas pero no entendemos para qué sirven esas cosas.

Mi objetivo hoy es que entiendas para qué sirve el archivo robots.txt

El robots txt va a ayudar a gestionar el rastreo de las páginas web por los diferentes bots, arañas, crawlers, rastreadores (llámalos cómo quieras) de los buscadores.

Gracias al archivo robots también podemos impedir que los buscadores rastreen determinados archivos.

Lo que debemos tener claro es que el archivo robots txt no sirve para impedir la indexación, para eso debemos usar la etiqueta no index y no introducir la url en el sitemap. Otros métodos pueden ser proteger la página con una contraseña.

Muchas veces, perdóneme padre porque he pecado, ponemos un no follow a una página para evitar su indexación. Sin embargo, si esta página está enlazada en otro punto de la web puede terminar en los resultados de búsqueda.

¿Dónde se ubica el archivo robots ? Reglas que debemos tener en cuenta

El robots. txt se ubica en la raíz del dominio y sirve para el dominio, aunque si existieran subdominios éstos necesitan su propio archivo robots.txt.

Una de las particularidades del archivo robots es que no es obligatorio, solo es recomendable.

Algunas reglas que debemos tener en cuenta son:

- El archivo debe llamarse robots.txt

- Solo debemos tener un archivo robots por sitio

- Debemos incluirlo en la raíz del dominio.

- También se pueden aplicar a subdominios.

- Deben ser codificados en UTF-8

Por tanto para crear nuestro archivo robots podemos servirnos del bloc de notas de nuestro ordenador pero no de procesadores de texto como microsoft word.

Entiende de qué va, para qué sirve y cómo configurar tu archivo robots.txt #fuckingSEO Compartir en XDirectivas que admite el archivo robots.

Las directivas son las reglas que leen los diferentes crawlers y siempre van a ser: user-agent, allow, disallow y sitemap.

Vamos a ver en qué consisten cada una de estas reglas de las que se compone un archivo robots.txt.

User-Agent

El user-agent hace alusión al bots al que va dirigida las reglas que ubicamos justo debajo de esa línea.

Cada conjunto de reglas que introduzcamos en el robots.txt deben estar orientadas a un rastreador, o lo que es lo mismo: cada conjunto de reglas deben estar orientadas a un user-agent.

Cuando ponemos un asterisoc (*) como user-agent es aplicable a todos los crawlers o rastreadores.

Digamos que el asterisco es el comodín.

Aunque hay una excepción: el asterisco no sirve para que los adsbots (los rastreadores de publicidad). A estos crawlers debemos crearle un conjunto de reglas explícitamente para ellos.

Cuando introducimos varios user-agent en el robots, el rastreador en cuestión va a hacer caso exclusivamente a su bloque de directivas y va a descartar el resto.

Disallow

En cada una de las directivas que introduzcamos en el robots debe haber al menos una línea que incluya disallow o allow.

Esta regla indica qué directorio o página de tu dominnio no quieres que rastree el user-agent.

No debemos incluir la url completa del mismo modo que aparece en el navegador. Solo debemos incluir lo que va tras el «.com» y debe comenzar con «/» y puede ser la url de la página o bien una carpeta y terminar también con la barrita.

Ejemplos:

Si no quiero que rastree la página de contacto:

Disallow: /contacto/

Si no quiero que rastree la carpeta del podcast SEO:

Disallow: /category/podcast-seo/

Allow

Cómo decíamos antes, en cada regla que introduzcamos debe tener al menos una línea que incluya allow o disallow.

Esta directiva qué directorios o páginas queremos que rastreen los crawlers de los buscadores.

Además, sirve para ayudar a generar una excepción al disallow o para anlularlo.

Funciona del mismo modo que el disallow: comenzar con «/» y si es una página, ponerla de la misma manera en la que aparece en el navegador. En el caso de que sea un directorio, incluir la carpeta entre «/».

Sitemap

Es interensante incluir el sitemap en nuestro archivo robots.txt, de esta forma indica a los rastreadores la ubicación del sitemap y así facilitamos el contenido que queremos que se tenga en cuenta para la indexación.

El asterisco lo podemos usar en cualquier regla exceptuando en la directiva del sitemap. Además, lo podemos poder usar en cualquier ubicación dentro de una ruta.

El URL del sitemap es el único que debe incluirse completo en el archivo robots.

Cómo crear un archivo robots.txt en 3 pasos

El archivo robots.txt debe estar formado por un grupo que lo conforman los siguientes elementos:

- User-agent

- Uno o más allow o disallow

Eso es un bloque y cada robots.txt puede tener varios bloques y cada bloque debe estar orientado a un user-agent. Un ejemplo de un bloque del archivo robots sería:

User-agent: *

Disallow: /2018/

Allow: /2018/premio-somos-los-mejores/

Lo que estamos diciendo es que a cualquier rastreador que se pase por nuestra web no rastree la carpeta del 2018. Sin embargo, en esta carpeta hay un conenido de un premio que recibimos que sí quiero que la rastree.

Cómo decíamos antes, el archivo debe tener la codificación UTF-8. Puedes hacerlo con el bloc de notas.

Ahora que sabemos los elementos que conforman el archivo robots vamos a montarlo. Para crear el robots.txt debemos agregar unas series de reglas que son las que le van a a decir a los rastreadores qué deben o no rastrear.

Cómo añadir reglas al archivo robots.

- Constan de uno o varios grupos

- Cada grupo consta de varias reglas

- Añadir una regla por línea

- Cada grupo debe empezar especificando el user-agent

- En cada grupo debemos aportar la siguiente información:

- A qué rastreadores se dirige la información (user-agent)

- A qué directorios o archivos no puede acceder ese rastreador

- A qué directorios o archivos puede acceder ese rastreador

- En las reglas se diferencia entre mayúsculas y minúsculas.

- Del mismo modo que en html, la almohadilla (#) marca el inicio de un comentario.

- Agregar al final de todas las directivas del robots el sitemap ayuda a facilitar el rastreo de la web para su posterior indexación.

Probar que el archivo robots txt funciona correctamente.

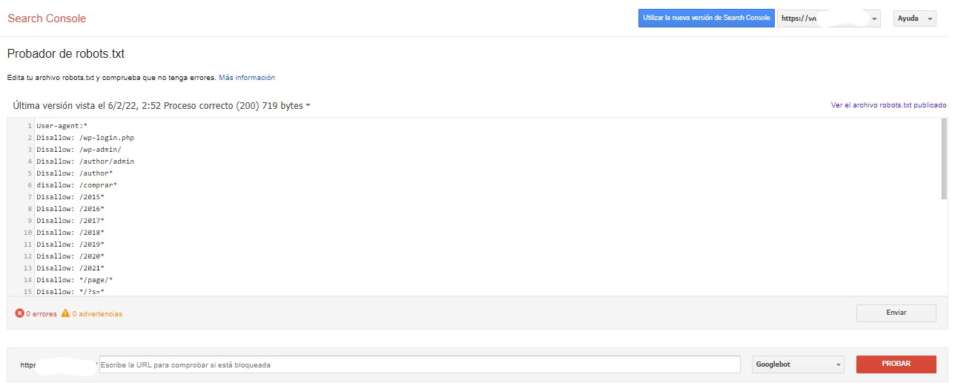

La mejor forma de comprobar si el robots txt funciona es mediante Google Search Console.

La herramienta de probador de robots txt nos ayuda a comprobar la accesibilidad a determinadas páginas.

De esta forma podremos saber si hemos configurado bien el archivo robots o si hemos bloqueado algo que no deberíamos haber bloqueado.

Tras probar que las directivas de nuestro robots txt están correctas lo siguiente que tienes que hacer es…nada.

Con esto, la siguiente vez que los rastreadores accedan a tu página web los crawlers saben a qué atenerse cuando realicen su rastreo.

Todo lo que debes saber y no te atreviste a preguntar sobre el archivo robots.txt #fuckingSEO Compartir en XCómo crear un archivo robot txt paso a paso

Todo esto que te comento relacionado con directivas del robots, formato y ubicación lo tenenmos que plasmar en nuestro archivo robots. Aprovechando que tenía que optimizar mi robots he grabado éste vídeo para enseñarte cómo se hace:

Limitaciones a tener en cuenta del archivo robots.

- Debemos tener claro que estas reglas son lentejas: los propios rastreadores son los que deciden si siguen las directivas o no.

- También debemos tener en cuenta que cada rastreador entiende la sintaxis de una forma…

- Como dijimos: cabe la posibilidad de que hayamos puesto una página con disallow y que a pesar de ello forme parte de la hoja de resultados de los buscadores por estar enlazada desde otros lugares.

- Si la página no es rastreable, Google no puede indexarla. Pero ojímetro: puede mostrar un fragmento de esa página en las SERPs

- El único bloque que no debe contener la línea de user-agent es el del sitemap.

Coincidencia en URLs y cómo trabajarlas en el robots.txt

Dentro de una página existen muchas urls que tienen una sintaxis común y para abordarlas en el archivo robots es preciso una serie de parámetros que nos hagan más sencilla la tarea.

Te dejo una serie de parámetros que te van a ser de gran utilidad a la hora de configurar tu archivo robots:

- El asterisco (*). Es el comodín y lo que indica que cualquier caracter es válido.

- El símbolo del dolar ($) nos indica el final de una URL

Si ponemos, por ejemplo:

disallow: /mark*.jpg –> le estamos diciendo que cualqueir ruta que comience por mark y termine en .jpg no sea rastreada.

Esta ruta implica que no rastree, por ejemplo:

- marketing-de-contenidos.jpg

- marketeros.jpg

- markate-un-gol.jpg

Prioridades a la hora de seguir las directivas de archivo robots

Cuando un rastreador o crawler llega a nuestro dominio raíz y se encuentra con el archivo robots.txt, prioriza teniendo en cuenta el siguiente orden:

- La especificidad manda. O lo que es lo mismo: priorizan la regla más concreta en base a la longitud de su ruta.

- En el caso de que haya directivas que entren en conflicto, Google se decanta por la que sea más laxa (menos restrictiva).

De primeras, Google rastrea absolutamente todo.

Por tanto, en el robots no debemos incluir a las bravas la directiva allow porque esta directiva solo se usa para anular el disallow anterior (marcando una excepción).

Conclusiones a la hora de configurar el archivo robots.txt

Configurar bien el archivo robots es una muy buena forma de optimizar el rastreo de nuestra página web y de tener controlado aquelló que queremos que vean los rastreadores web.

No lo debemos hacer deprisa y corriendo, para cofigurarlo bien debemos analizar todas las urls que tenemos, incluyendo aquellas que se generan en las búsquedas intenernas o cuando compartimos nuestro contenido en facebook.

Del mismo modo, debemos tener especial cuidado con todo lo que metemos en disallow porque puede que bloqueemos una url que es importante de cara a nuestro posicionamiento.

Por eso, tan importante es tomarse tiempo a la hora de configurar nuestro archivo robots como lo es tomarse tiempo para comprobar que funciona perfectamente para las páginas relevantes de cara a nuestro posicionamiento.

Ahora que ya sabes esto, ¿te animas a optimizar tu archivo robots?

Comparte Robots txt: Qué es y cómo crear el archivo robots. en tus Redes Sociales

También te puede interesar...

Franky Martin

Posted at 09:38h, 20 febreroHola Lucía,

gracias por la información!!

Tengo un problema con el disallow de las páginas legales y pensaba que podrías ayudarme.

He añadido al robots.txt;

User-Agent: *

Disallow: /aviso-legal/

Pero al comprobar si funciona veo que no se bloquea el rastreo de a esa url

«matching rule was not found»

Uso Yoast SEO y edito el rbotos.txt con su editor de archivos.